核心价值

MQM9790-NS2F 是为大规模数据中心和高性能计算设计的 高密度 400 Gb/s InfiniBand 交换机,提供 51.2 Tb/s 聚合带宽与亚微秒级延迟。它通过原生 RDMA 支持和 SHARPv3 网络内计算加速,为 AI 训练、HPC 及云基础设施构建高效、可扩展的互连骨干。

产品核心亮点

64×400Gb/s 高密度端口

通过 32 个 OSFP 物理接口实现 64 个 NDR 400 Gb/s 逻辑端口,单台设备即可汇聚海量服务器流量,极大提升机柜顶部(ToR)或核心交换层的端口密度。

51.2 Tb/s 超高带宽

提供高达 51.2 Tb/s 的聚合双向吞吐量,满足大规模AI集群与HPC应用对无阻塞、全线速数据交换的严苛要求。

超低延迟与先进拥塞控制

基于 InfiniBand 架构的 RDMA 技术实现亚微秒级延迟。内置自适应路由与拥塞控制机制,保障关键任务在高负载下的 QoS 与性能稳定。

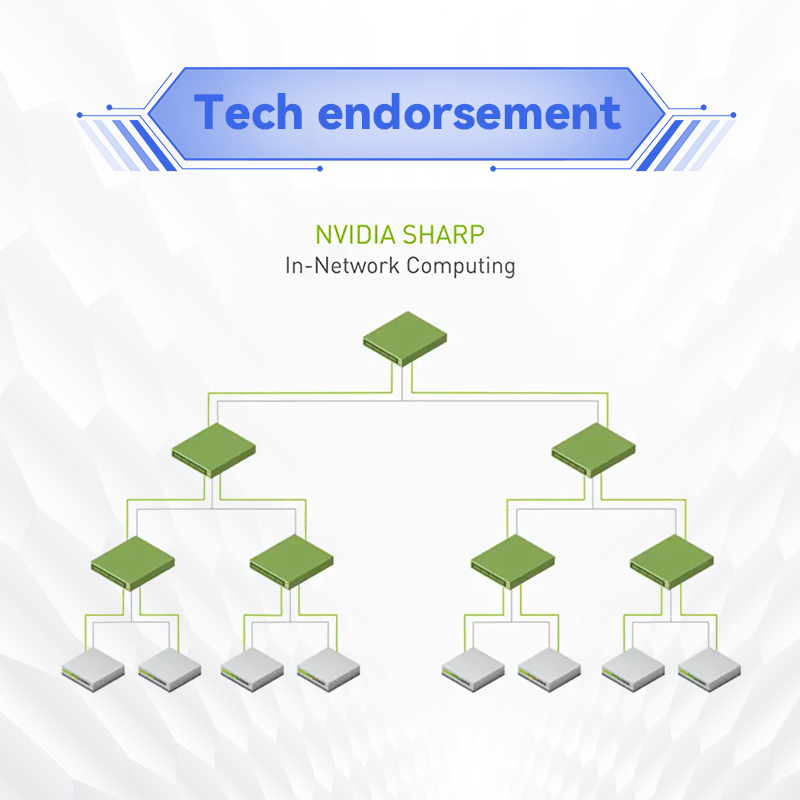

网络内计算加速 (SHARPv3)

支持 Scalable Hierarchical Aggregation and Reduction Protocol (SHARP),可在交换机网络内直接执行聚合操作,将 AI 训练和 HPC 的集体通信性能提升高达数倍。

详细技术规格

典型应用场景

数据中心核心/汇聚交换

作为下一代数据中心的骨干交换节点,提供大规模 400Gb/s 端口密度,用于服务器汇聚或Spine层核心互连,构建高带宽、低延迟的Clos网络。

AI 与深度学习训练集群

通过 RDMA 和 SHARPv3 网络内计算加速,显著减少大规模 GPU 集群在参数同步时的通信开销,将大模型训练效率提升至新高。

高性能计算 (HPC) 系统

为气象模拟、基因测序、流体力学等大规模并行计算任务提供超高吞吐和超低延迟的网络平面,确保计算节点间高效协同。

大规模云基础设施

为公有云或超大规模私有云平台构建高性能、可扩展的底层InfiniBand网络,支撑计算、存储(如NVMe over Fabrics)网络的融合与性能隔离。

产品优势总结

MQM9790-NS2F 以行业领先的端口密度(64×400Gb/s)和超高带宽(51.2Tb/s),结合 InfiniBand 固有的低延迟、高吞吐优势及 SHARPv3 网络计算加速功能,成为构建下一代 AI 集群、HPC 系统和云数据中心的理想核心网络设备。其 1U 紧凑设计、MLNX-OS 的全面可管理性及向下兼容多种速率,确保了卓越的性能、灵活的部署与长期的投资保护。

搜索关键词:MQM9790-NS2F, 400Gb/s InfiniBand 交换机, NDR 交换机, 64端口 InfiniBand, 高性能计算交换机, AI 网络交换机, SHARPv3, Mellanox 交换机, 数据中心核心交换机, 1U 400G 交换机